Pliops ускорила работу ИИ в 8 раз с помощью быстрых SSD

Компания Pliops представила технологию, которая позволяет значительно ускорить обработку данных в больших языковых моделях (LLM). Решение основано на использовании быстрых SSD вместо дорогостоящей памяти GPU (HBM) и, по заявлениям разработчиков, может ускорять некоторые процессы инференса в восемь раз.

Проблема в том, что современные ИИ-модели требуют всё больше оперативной памяти для работы с длинными контекстами. Когда данных становится слишком много, система вынуждена постоянно пересчитывать информацию, что замедляет работу и увеличивает нагрузку на GPU. Pliops предлагает хранить часть вычисленных данных на SSD и мгновенно подгружать их при необходимости, снижая, таким образом, задержки и экономя ресурсы.

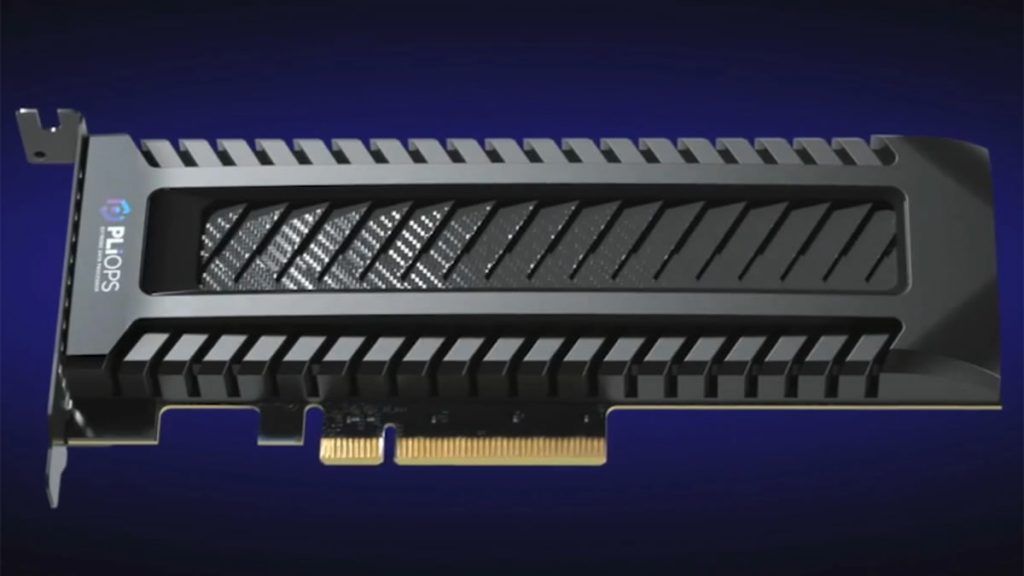

Для этого используется устройство XDP LightningAI и программное обеспечение FusIOnX. Устройство подключается через PCIe и управляет передачей данных между GPU и SSD, а софт обеспечивает эффективное чтение и запись. Решение совместимо с популярными фреймворками, такими как vLLM и Nvidia Dynamo, и работает как с одиночными GPU, так и с масштабными серверными системами.

Главное преимущество технологии в возможности обрабатывать больше данных без увеличения числа GPU. Обычно для расширения памяти HBM приходится добавлять новые видеокарты, но их количество в одной системе ограничено. Pliops предлагает более дешёвую альтернативу с почти такой же скоростью, что позволяет снизить общую стоимость владения ИИ-инфраструктурой.

По словам представителей компании, их подход обеспечивает стабильную работу больших моделей даже при высокой нагрузке, что особенно важно для сервисов, где критичны скорость и масштабируемость, таких как чат-боты или системы автоматического перевода. В будущем подобные решения могут стать стандартом для энергоэффективных ИИ-систем.

Добавьте Hdhai в избранное и вы будете чаще видеть наши последние новости на главной Дзена и в разделе «Новости партнёров» или читайте нас в Telegram в привычном для вас формате.