Новое исследование развенчивает миф о «рассуждающем» ИИ

Ученые выяснили, что даже самые продвинутые модели спотыкаются на задачах, требующих глубокого логического мышления. Gemini, Claude и Grok провалили тест на математические доказательства.

В новейших ИИ-моделях, которые якобы могут рассуждать, существует любопытное противоречие: они могут справляться с рутинными математическими задачами с высокой точностью, но когда дело доходит до формулирования глубоких математических доказательств, встречающихся на уровне соревнований, они зачастую дают сбой.

К такому выводу пришли исследователи, опубликовавшие свой препринт 27 марта 2025 года. Работа проливает свет на математические ограничения моделей имитации рассуждений (Simulated Reasoning, SR), несмотря на громкие маркетинговые заявления компаний-разработчиков ИИ.

Модели имитации рассуждений отличаются от традиционных больших языковых моделей (LLM) тем, что они обучены выводить пошаговый процесс мышления, часто называемый цепочкой рассуждений, для решения задач. Важно отметить, что имитация не означает полное отсутствие рассуждений — просто ИИ не обязательно используют те же методы, что и люди. «Это различие важно, потому что само человеческое мышление трудно определить», — подчеркивают авторы исследования.

Новая статья под названием «Доказательство или блеф? Оценка LLM на олимпиаде США по математике 2025» была подготовлена командой исследователей из ETH Zurich и INSAIT при Софийском университете под руководством Иво Петрова (Ivo Petrov) и Мартина Вечева (Martin Vechev).

В ходе исследования модели SR были протестированы на задачах с олимпиады США по математике 2025 года, организованной Математической ассоциацией Америки. Большинство моделей показали средний результат менее 5% правильных ответов при попытке сгенерировать полные математические доказательства. Одна из моделей продемонстрировала заметно лучшие, но все ещё ограниченные, результаты. Этот показатель представляет собой средний процент от общего количества возможных баллов (выставляемых по стандартной шкале 0–7 за каждую задачу, как на официальной олимпиаде), достигнутый моделями в нескольких попытках. При этом баллы за правильные шаги начислялись экспертами-людьми.

ИИ не справляется с доказательствами

Чтобы понять, почему этот пробел в возможностях имеет значение, нужно различать ответы на математические задачи и математические доказательства. Математические задачи подобны вопросам: «Сколько будет 2+2?» или «Решите уравнение для x». Здесь требуется только правильный ответ. Однако математические доказательства больше похожи на вопросы: «Объясните, почему 2+2=4, используя логические шаги» или «Докажите, что эта формула работает для всех возможных чисел». Доказательства требуют объяснения рассуждений и демонстрации того, почему что-то должно быть истинным, а не просто предоставления ответа.

Математическая олимпиада США (USAMO) служит квалификацией для Международной математической олимпиады и ставит значительно более высокую планку, чем тесты вроде American Invitational Mathematics Examination (AIME). Если задачи AIME сложны, но требуют целочисленных ответов, то USAMO обязывает участников записывать полные математические доказательства, которые оцениваются по критериям корректности, полноты и ясности на протяжении девяти часов, разделенных на два дня.

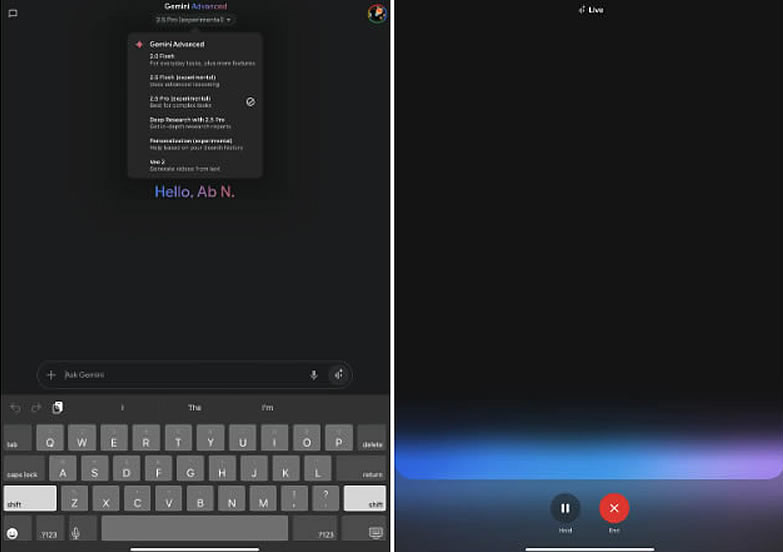

Исследователи оценили несколько моделей ИИ на шести задачах из USAMO 2025 года вскоре после их публикации, минимизировав вероятность того, что задачи могли быть частью обучающих данных моделей. Среди протестированных моделей были Qwen QwQ-32B, DeepSeek R1, Google Gemini 2.0 Flash Thinking (Experimental) и Gemini 2.5 Pro, OpenAI o1-pro и o3-mini-high, Anthropic Claude 3.7 Sonnet with Extended Thinking, а также xAI Grok 3.

Хотя одна из моделей, Google Gemini 2.5 Pro, показала более высокий средний балл — 10,1 из 42 возможных (~24 процента), остальные результаты продемонстрировали значительное падение производительности по сравнению с тестами уровня AIME. Эти модели значительно отстали — DeepSeek R1 и Grok 3 набрали в среднем по 2,0 балла, Google Flash-Thinking — 1,8 балла, Anthropic Claude 3.7 — 1,5 балла, а Qwen QwQ и OpenAI o1-pro обе в среднем получили по 1,2 балла. Самый низкий средний балл — всего 0,9 балла (~2,1 процента) — был у OpenAI o3-mini. Из почти 200 сгенерированных решений, созданных всеми протестированными моделями, ни одно не получило максимальный балл ни по одной из задач.

Хотя недавно выпущенные модели OpenAI, такие как o3 и o4-mini-high, не рассматривались в этом исследовании, тесты на сайте MathArena, созданном исследователями, показывают, что o3-high набрал в среднем 21,73%, а o4-mini-high — 19,05% на задачах USAMO. Однако эти результаты потенциально могут быть искажены, поскольку они были измерены после проведения конкурса, а значит, новые модели OpenAI могли включать решения в свои обучающие данные.

Когда ИИ-модели заблуждаются

В своей статье исследователи выявили несколько ключевых повторяющихся паттернов ошибок. В выводах ИИ наблюдались логические пробелы, где отсутствовало математическое обоснование, использовались аргументы, основанные на недоказанных предположениях, и продолжали генерироваться неверные подходы, даже когда возникали противоречивые результаты.

Одним из конкретных примеров стала задача 5 USAMO 2025 года. В этой задаче требовалось найти все положительные целые числа "k", такие, что определенное вычисление с суммами биномиальных коэффициентов, возведенных в степень "k", всегда давало целое число, независимо от того, какое положительное целое число "n" использовалось. Модель Qwen QwQ допустила заметную ошибку, заключающуюся в некорректном исключении нецелочисленных возможностях на этапе, где формулировка задачи их допускала. Эта ошибка привела модель к неверному итоговому ответу, несмотря на то, что необходимые условия были корректно выявлены на более ранних этапах рассуждений.

Особенно примечательно, что эти модели ИИ часто выдавали неверные решения, используя утвердительный язык, не демонстрируя при этом никаких признаков неуверенности или «осознания» ошибок в процессе имитации рассуждений. Исследователи отметили эту тенденцию даже в тех случаях, когда доказательства содержали значительные изъяны.

Учёные предположили, что эти неудачи могут частично объясняться тем, как модели обучались и оптимизировались. Например, они наблюдали артефакты, вероятно возникшие в результате стратегий оптимизации, распространенных при обучении на тестовых данных. Модели иногда некорректно накладывали ограничения, связанные с поиском финального «заключенного в рамку» ответа (отсылая к распространенной практике в тестах, где модели должны форматировать свой окончательный числовой результат, часто используя команду LaTeX \\boxed{}, чтобы автоматизированные системы могли легко извлечь и оценить его), даже когда это было неприменимо для доказательства. Кроме того, они чрезмерно обобщали закономерности, наблюдаемые в небольших примерах, не предоставляя требуемого обоснования.

Иллюзия математической грамотности

Выявленный разрыв в производительности между решением математических задач и доказательствами демонстрирует различие между распознаванием паттернов и подлинным математическим рассуждением. Современные модели SR хорошо справляются с задачами, где похожие паттерны встречаются в обучающих данных, что позволяет давать относительно точные числовые ответы. Однако им не хватает более глубокого «концептуального понимания», необходимого для математики на основе доказательств, которая требует построения новых логических аргументов, представления абстрактных концепций и корректировки подходов, когда первоначальные методы терпят неудачу.

Так почему же цепочки рассуждений и имитация мышления улучшают результаты, если они не выполняют более глубокий процесс математического рассуждения? Ответ кроется в том, что исследователи называют масштабированием «вычислений во время вывода». Когда LLM используют технику цепочек рассуждений, они направляют больше вычислительных ресурсов на прохождение скрытого пространства (связей между концепциями в данных их нейронной сети) более мелкими и целенаправленными шагами. Каждый промежуточный шаг рассуждений служит контекстом для следующего, эффективно ограничивая выводы модели таким образом, чтобы это повышало точность и снижало вероятность выдумывания фактов.

Как объясняет инженер-исследователь LLM Себастьян Рашка (Sebastian Raschka) в своем блоге: «Модели рассуждений либо явно демонстрируют свой мыслительный процесс, либо обрабатывают его внутренне, что помогает им лучше справляться с сложными задачами, такими как математические проблемы».

Однако, по сути, все ИИ-модели, основанные на архитектуре глубоких нейронных сетей, являются машинами для сопоставления паттернов. Они заимствуют навыки рассуждений из примеров в данных, которые исследователи используют для их создания. Это объясняет любопытную закономерность, выявленную в олимпиадном исследовании, в частности, эти модели преуспевают в стандартных задачах, где пошаговые процедуры совпадают с паттернами в их обучающих данных, но терпят неудачу при столкновении с новыми задачами на доказательство, требующими гораздо более глубокого математического понимания. Улучшение, вероятно, связано с повышением статистической вероятности в нескольких небольших предсказательных задачах, а не с одним большим скачком в предсказании.

Тем не менее, на примере результатов Gemini 2.5 Pro видно, как модели SR могут со временем сократить этот «рассуждающий» пробел, поскольку они становятся более способными и могут выстраивать более глубокие многомерные связи в скрытом пространстве. Будущие методы обучения или архитектуры моделей, возможно, в конечном итоге научат ИИ всем необходимым паттернам рассуждений, чтобы достичь уровня глубокого мышления, сопоставимого с лучшими человеческими умами. Но пока этого не происходит.

Почему текущие ИИ не осилят математику

Даже при наличии потенциальных улучшений, текущие результаты исследования предполагают, что простое масштабирование существующих архитектур моделей SR и методов обучения может не преодолеть разрыв до подлинного математического рассуждения. В другом недавнем исследовании, упомянутом Гэри Маркусом (Gary Marcus) в его блоге о статье «Доказательство или блеф», Хамед Махдави (Hamed Mahdavi) из Пенсильванского государственного университета и его соавторы из Городского университета Нью-Йорка, Нью-Йоркского университета и Autodesk оценили LLM на схожих сложных математических задачах, прийдя к идентичным выводам об этих ограничениях.

Учитывая выявленные недостатки, некоторые исследователи изучают альтернативные подходы для улучшения рассуждений ИИ. Среди них — интеграция символьного мышления, разработка более эффективных методов проверки доказательств и использование самосогласованных проверок. AlphaGeometry от DeepMind служит одним из примеров, сочетая нейронные сети с формальными методами, распространенными в символьном ИИ. Хотя такие «нейро-символьные системы» могут не найти доказательство, их структура исключает возможность выдумывания неверных рассуждений.

Источник: HDHai